Какой должна быть этика искусственного интеллекта

За последние шесть лет технология искусственного интеллекта приобрела огромную популярность. Разработки в этой сфере могут произвести революцию и изменить нашу повседневную жизнь. На фоне ажиотажа вокруг ИИ также высказываются опасения по поводу этических последствий его развития.

По мнению некоторых экспертов, риски не ограничиваются потенциальными дезинформационными атаками и выходят за пределы генеративных сервисов, распространяясь едва ли не на все сферы деятельности человека.

издание ForkLog рассмотрело основные концепции нравственного ИИ и его безопасность.

- Дебаты об этике искусственного интеллекта продолжаются с момента появления технологии.

- Алгоритмы, взаимодействующие с людьми, необходимо проверять на наличие рисков в соответствии с общепринятыми нормами морали.

- Искусственный интеллект не нужно делать похожим на человеческий.

- Ученые, техгиганты и правительства сходятся в основных принципах нравственного ИИ.

ОПРЕДЕЛЕНИЕ ЭТИКИ ИИ И ИСТОРИЯ ТЕРМИНА

Сама по себе этика — философская дисциплина, исследующая нравственность и мораль. Иными словами, она объясняет, что такое хорошо, а что такое плохо.

Этика искусственного интеллекта, в свою очередь, есть совокупность принципов ответственного ИИ — как он должен поступать, а как не должен. Эти принципы часто подразумевают безопасность, справедливость и ориентированность на человека.

Одними из первых тему «машинной морали» подняли писатели, работающие в жанре научной фантастики. В своих произведениях они рассуждали о поведении роботов, их разуме, чувствах и взаимодействии с человеком. Это течение получило название «робоэтика».

Популяризатором явления считается Айзек Азимов — автор рассказа «Хоровод». В нем писатель впервые сформулировал «Три закона робототехники». Позже в романе «Работы и империя» Азимов дополнил список нулевым правилом. Они звучат примерно так:

- Робот не может своим действием нанести вред человечеству, или в результате бездействия допустить, чтобы человечеству был причинен вред.

- Робот не может своим действием нанести вред человеку, или в результате бездействия допустить, чтобы человеку был причинен вред.

- Робот должен подчиняться приказам человека, за исключением случаев, когда эти приказы противоречат Первому закону.

- Робот должен защищать свою безопасность, пока она не противоречит Первому или Второму закону.

Законы Азимова приобрели популярность и вышли далеко за пределы его литературных произведений. Их до сих пор обсуждают писатели, философы, инженеры и политики.

По мнению ряда критиков, подобные нормы трудно реализовать на практике. Фантаст Роберт Сойер заявил, что бизнес не заинтересован в развитии коренных мер безопасности.

Однако у трансгуманиста Ганса Моравека противоположное мнение. По его словам, корпорации, использующие работы на производстве, могут использовать «сложный аналог» этих законов для управления техническим процессом.

Сформулированные Азимовым правила использовали и правительственные структуры. В 2007 году власти Южной Кореи разработали «Устав этических норм для роботов». Основные положения документа напоминают изложенные писателем постулаты.

В связи с применением роботов в военной сфере проблема стала более актуальна. В 2021 году ООН впервые зафиксировала убийство человека дроном с искусственным интеллектом, который самостоятельно определил цель, выследил ее и принял решение о ликвидации.

После популяризации генеративных алгоритмов типа GPT или DALL-E дискуссии об этике искусственного интеллекта расширились. Правительства стран обсуждают потенциальные риски и разрабатывают планы по регулированию технологии ИИ, а техгиганты активно развивают внутренние команды для создания безопасного ИИ.

«ПРОБЛЕМА ВАГОНЕТКИ»

Развитие технологий, прямо влияющих на жизнь людей, порождают целый ряд этических и моральных дилемм. Ярче всего их можно описать на примере беспилотных автомобилей: как должен поступить робокар в экстренной ситуации? Поставить под угрозу жизнь пассажира или пешехода?

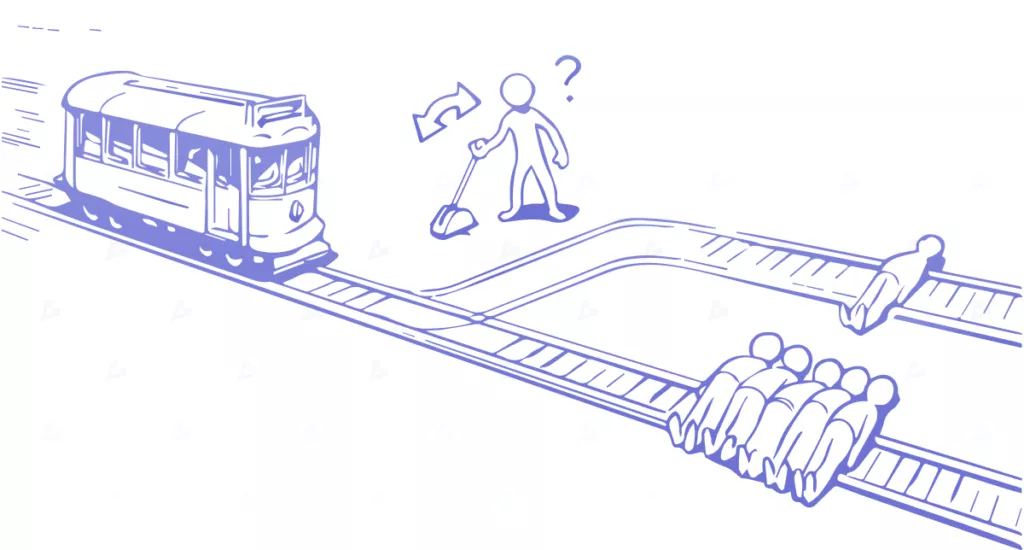

Эту дилемму хорошо иллюстрирует проблема вагонетки, которую в 1967 году сформировала английская философиня Филиппа Фут. Общее содержание задачи звучит так:

«Вагонетка потеряла управление и несется по железнодорожному пути. Впереди на путях привязаны и обездвижены пять человек. Вы стоите на определенном расстоянии от места событий у стрелки. Если вы переведете стрелку, вагонетка промчится по соседнему пути, однако там привязан один человек.

Вы не можете повлиять на ситуацию. Есть только два варианта: ничего не делать, и вагонетка убьет пять человек, или перевести стрелку и пожертвовать одной жизнью. Какой вариант верен?

Большинство моральных принципов можно переформатировать в подобные задачи и провести ряд экспериментов. В реальной жизни может оказаться гораздо больше вариантов, а последствия менее трагичны. Однако сделанный ИИ выбор будет так или иначе влиять на жизнь, и исключать все риски нельзя.

ИИ НЕ ДОЛЖЕН УЧИТЬСЯ У ЛЮДЕЙ

Несмотря на то, что моральные и этические принципы формирует человек, ИИ не должен походить на людей, поскольку в алгоритм могут проникнуть свойственные обществу предвзятости.

Это хорошо иллюстрирует технология распознавания лиц. Для создания релевантных систем собирается большой набор данных с изображением людей. Часто за процессом стоят автоматизированные боты, не учитывающие разнообразие выборки и контекст. В результате датасет вначале может оказаться пристрастным.

Следующий этап разработки – построение модели и тренировки. На этой стадии также могут проникнуть предубеждения и искажения, в том числе из-за проблемы «черного ящика». Инженеры просто не знают, почему алгоритм выносит то или иное решение.

Риски предвзятости существуют на уровне интерпретации. Однако на этом этапе уже большую роль играет человек. К примеру, алгоритм научили на определенной выборке людей и получили конкретные результаты. Затем применили систему к другой группе – данные кардинально изменились.

В 2021 году нидерландские активисты доказали наличие искажений в системе распределения социальной помощи. По их словам, ее использование нарушало права человека. В результате муниципальные власти отказались от эксплуатации ПО.

О проблеме с переносом данных сообщают и разработчики. В марте 2023 года группа исследователей разработала алгоритм, прогнозирующий риск появления рака поджелудочной железы. Для обучения системы исследователи преимущественно использовали медицинские записи пациентов датских клиник.

Ученые предупредили, что точность алгоритма при проектировании пациентов из США значительно снижается. Поэтому алгоритм следует переучить на данных американцев.

ПОПУЛЯРНЫЕ ПРИНЦИПЫ НРАВСТВЕННОГО ИИ

Исследовательские группы, правозащитники, техгиганты и правительства предлагают разные подходы, однако все они имеют ряд сходств. Рассмотрим самые популярные мнения.

СПРАВЕДЛИВОСТЬ И НЕДИСКРИМИНАЦИЯ

Системы искусственного интеллекта необходимо разрабатывать таким образом, чтобы свести к минимуму дискриминацию по признаку расы, пола, религии или других защищенных характеристик. Предупреждения в алгоритмах могут укрепить существующее неравенство и нанести вред определенным группам.

Например, системы распознавания лиц показали пристрастность в своей точности с более высоким уровнем ошибок для определенных расовых и гендерных групп. В 2019 году темнокожий житель штата Нью-Джерси (США) провел 10 суток в тюрьме из-за ошибки алгоритма. Подобные случаи были и в других городах, за что полиция столкнулась с волной критики из-за использования необъективных технологий.

Этические методы ИИ могут помочь выявить и смягчить такие предубеждения, способствуя справедливости при принятии решений.

ПРОЗРАЧНОСТЬ И ПОНЯТНОСТЬ

Прозрачность и ясность имеют решающее значение для укрепления доверия к ИИ. Системы необходимо создавать таким образом, чтобы их процессы и результаты принятия решений были понятны всем заинтересованным сторонам.

Разработчики генеративных систем рассматривают возможность применения водяных знаков для маркировки контента, созданного алгоритмами. Они считают, что это повысит осведомленность пользователей и предотвратит распространение дезинформации.

Другим примером прозрачного использования ИИ является закон штата Иллинойс (США) о конфиденциальности биометрических данных. Документ запрещает предприятиям использовать технологии типа распознавания лиц без явного сообщения пользователей.

В рамках закона компании типа Google и Clearview AI уже столкнулись с многомиллионными штрафами или ограничениями в деятельности.

Сторонники этого подхода считают, что прозрачность способствует ответственному принятию решений и предотвращает неправомерное использование систем ИИ.

ПОДОТЧЕТНОСТЬ И ОТВЕТСТВЕННОСТЬ

Заинтересованные стороны должны нести ответственность за разработку и использование систем ИИ, а также их потенциальное влияние на людей, общество и окружающую среду. Им нужно обеспечить полезное внедрение технологии.

Это включает рассмотрение этических последствий внедрения ИИ-систем и активное участие в принятии решений на протяжении всего процесса разработки и развертывания.

КОНФИДЕНЦИАЛЬНОСТЬ И ЗАЩИТА ДАННЫХ

Системы искусственного интеллекта часто используют персональную информацию и обеспечение конфиденциальности является важным фактором. Этические методы ИИ включают получение согласия на сбор и использование данных. Также необходимо обеспечить контроль над тем, как поставщики услуг располагают сведениями о пользователях.

Это гарантирует соблюдение прав на неприкосновенность личной жизни и защиту личной информации, считают эксперты.

По этой причине в конце марта 2023 года ChatGPT заблокирован в Италии. Местный регулятор обвинил разработчиков в незаконном сборе личных данных, что заставило OpenAI ввести более прозрачные методы работы.

Вероятно, чтобы не столкнуться с такими же проблемами, глобальное развертывание чат-бота Bard компании Google обошло стороной не только ЕС, где действует GDPR, но и весь европейский континент.

ЧЕЛОВЕКОЦЕНТРИЧНОСТЬ

Этический ИИ ставит во главу угла человекоцентричность. Это значит, что алгоритмы необходимо разрабатывать для расширения возможностей людей, а не замену им.

Принцип включает рассмотрение потенциального влияния ИИ на рабочие места, социальную динамику и всеобщее благосостояние, а также обеспечение соответствия технологии человеческим ценностям.

БИЗНЕС И ЗАКОН

Соблюдение этических норм ИИ – это ответственное поведение. Они также необходимы для получения коммерческой выгоды. Вопросы этики могут быть бизнес-риски, такие как неудачи в производстве продукции, юридические проблемы или репутационные убытки бренда.

Теоретически использование алгоритмов слежения за поставщиками в Amazon может обезопасить водителей. Однако работники оказались недовольны злоупотреблением наблюдением, что вызвало шум в СМИ, а топ-менеджменту пришлось оправдываться.

Между тем Гильдия сценаристов объявила крупнейшую за 15 лет забастовку, частично связанную с распространением генеративного ИИ. Авторы требуют запретить или ограничить использование технологии в писательском деле и пересмотреть зарплаты.

Чем закончится текущий протест, неизвестно. Однако стодневная забастовка в 2007-2008 годах обошлась бюджету Калифорнии в $2,1 млрд.

Одной из причин подобных событий может являться бесконтрольное развитие и использование алгоритмов. Тем не менее, отдельные страны и даже города применяют свои подходы к моральной стороне вопроса. Это означает, что компаниям необходимо знать правила II на уровне юрисдикции, в рамках которой они осуществляют деятельность.

Яркими примерами являются положения «Право на объяснение» в GDPR и соответствующие разделы Калифорнийского закона о конфиденциальности потребителей.

Некоторые американские города на местном уровне приняли решение об ограничении использования алгоритмов. В ноябре 2022 года власти Нью-Йорка запретили пристрастные ШИ-системы для рекрутинга. До этого в городе вступило в силу постановление, обязывающее частные заведения обеспечить конфиденциальность биометрических данных посетителей.

Этический ИИ имеет важное значение в разработке и внедрении технологий. Он может обеспечить справедливость, прозрачность, конфиденциальность и ориентированность человека для благоприятного развития общества.

Кроме этого, применение руководящих принципов способно обеспечить компаниям коммерческую выгоду, в частности, предотвращая беспокойство сотрудников, потребителей и других заинтересованных лиц.

Споры и прения вокруг ИИ способны перерасти в конструктивный диалог. Чрезмерное регулирование может помешать развитию технологии и погубить нераскрывшийся потенциал. Поэтому сейчас существует необходимость поиска выверенных решений в области нравственного использования ИИ, которое удовлетворит максимально возможное количество людей.